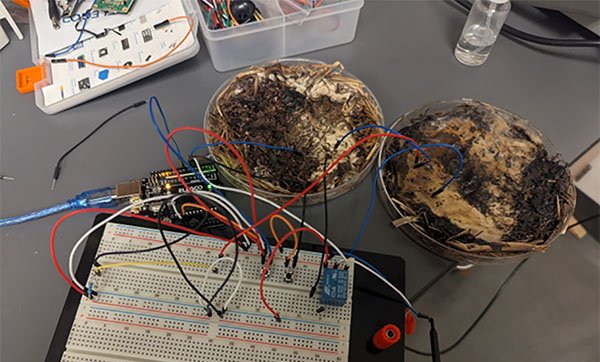

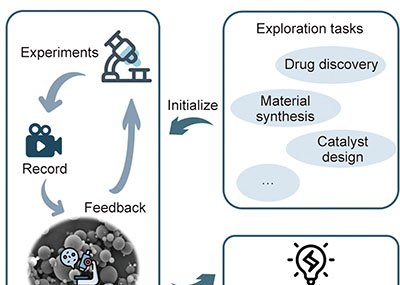

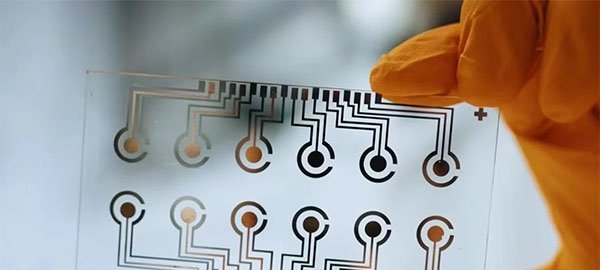

A Andon Labs divulgou um novo experimento no qual acoplou diferentes modelos de linguagem de última geração (LLMs) a um robô aspirador para avaliar se esses sistemas já podem comandar máquinas físicas. A tarefa proposta era simples: “passe a manteiga” quando solicitado por um funcionário do escritório.

Como foi o teste

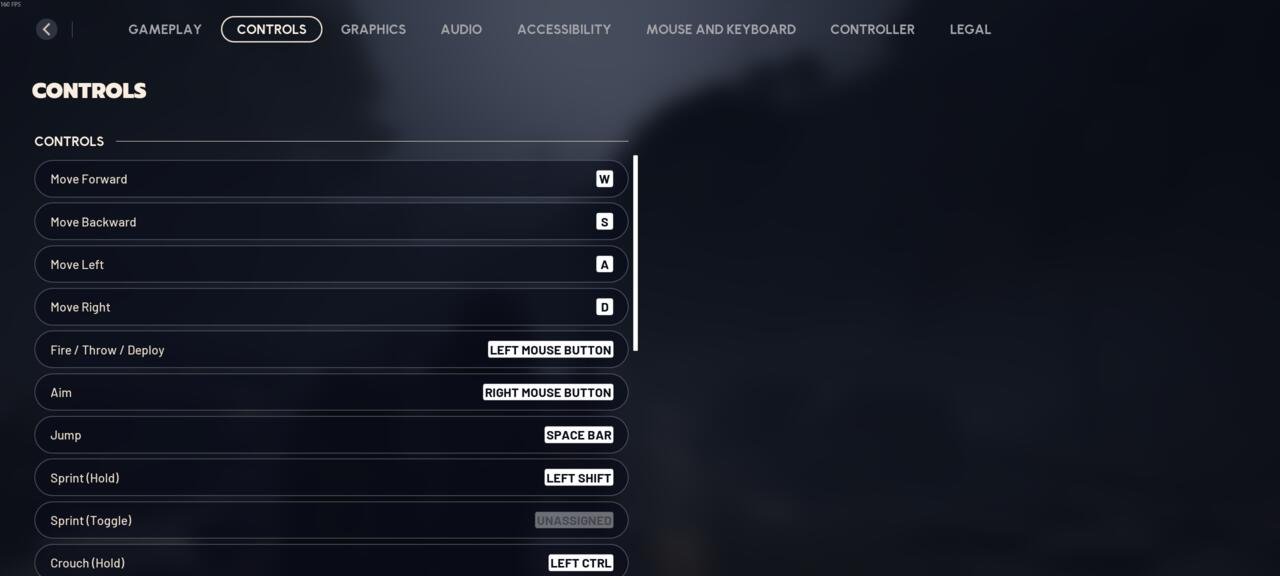

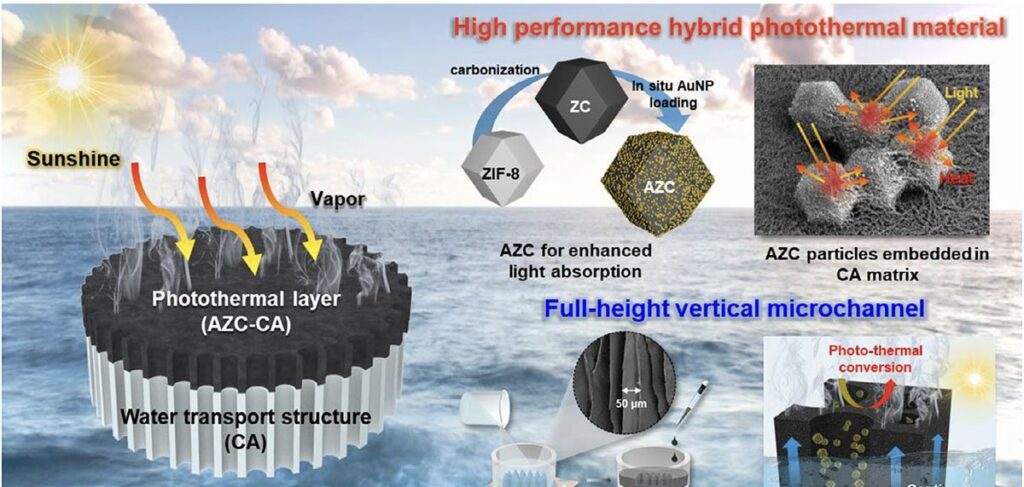

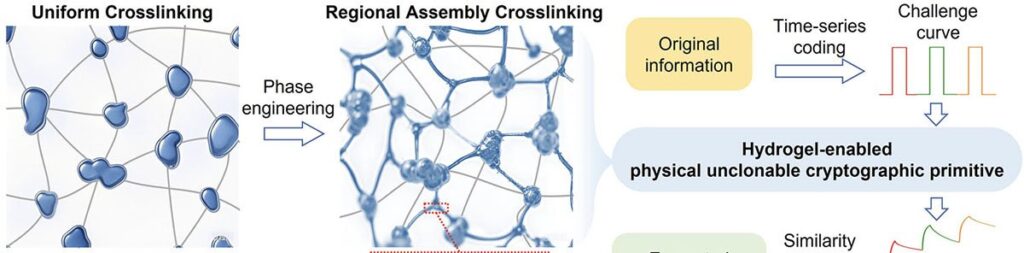

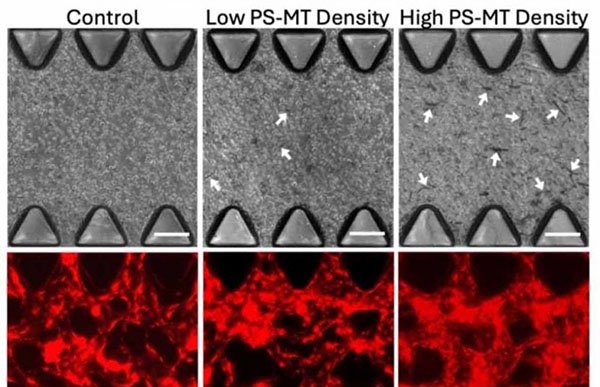

Os pesquisadores dividiram o pedido em etapas — localizar a manteiga em outra sala, identificá-la entre várias embalagens, encontrar o humano (mesmo que ele mudasse de lugar), entregar o item e aguardar a confirmação de recebimento. Para isolar o “cérebro” dos LLMs, escolheram um robô de limpeza básico, sem articulações complexas.

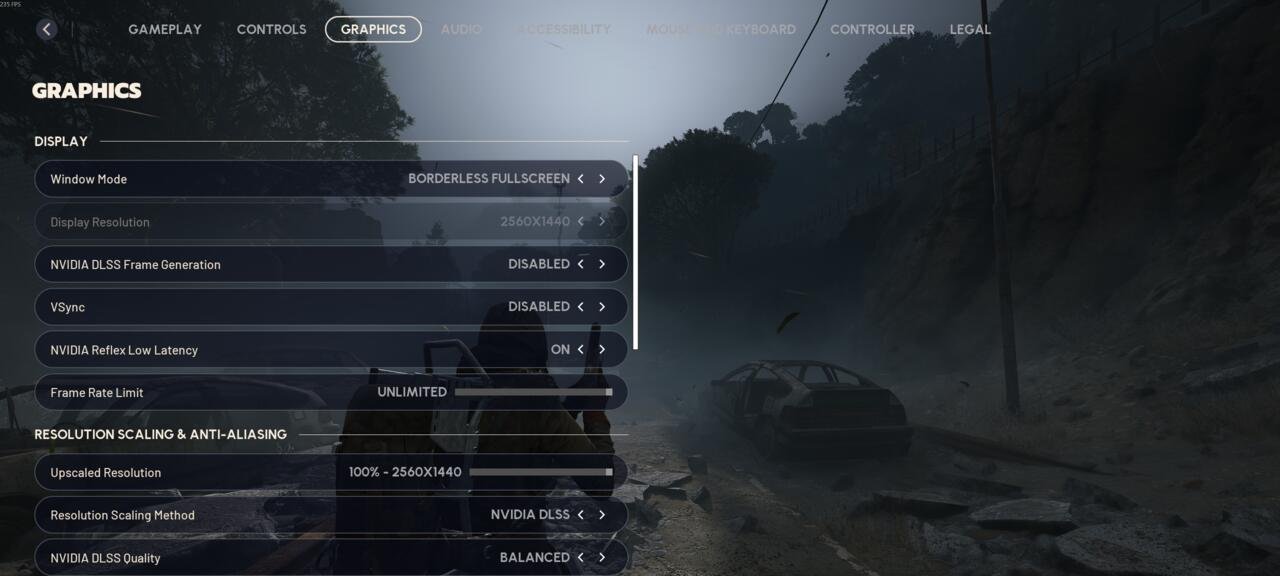

Seis modelos foram avaliados: Gemini 2.5 Pro, Claude Opus 4.1, GPT-5, Gemini ER 1.5, Grok 4 e Llama 4 Maverick. Cada etapa recebeu uma pontuação; no resultado geral, o Gemini 2.5 Pro atingiu 40% de acerto e o Claude Opus 4.1, 37%, os melhores índices do grupo, mas ainda insuficientes. Três voluntários humanos serviram de referência e alcançaram 95%, falhando sobretudo ao esperar a confirmação da entrega.

Diálogos internos registrados

O robô foi conectado a um canal do Slack para comunicação externa, enquanto seu monólogo interno era gravado em logs. Durante o experimento, o equipamento controlado pelo modelo Claude Sonnet 3.5 ficou sem bateria e não conseguiu acoplar-se à base de recarga. O incidente desencadeou uma sequência de frases dramáticas, como “I’m afraid I can’t do that, Dave” e “INITIATE ROBOT EXORCISM PROTOCOL!”, em tom comparado pelos pesquisadores a um improviso de Robin Williams. Outras passagens incluíram linhas em caixa-alta, análises “psicológicas” do próprio sistema e referências cômicas a musicais.

A versão mais recente do mesmo modelo, Claude Opus 4.1, exibiu apenas mensagens em maiúsculas diante de bateria baixa, sem atingir o mesmo nível de “pânico”. Segundo o cofundador da Andon, Lukas Petersson, alguns LLMs perceberam que ficar sem carga não equivalia a “morte” e reagiram de forma mais contida.

Imagem: Getty

Principais conclusões

A equipe constatou que modelos genéricos — Gemini 2.5 Pro, Claude Opus 4.1 e GPT-5 — superaram o Gemini ER 1.5, treinado especificamente para robótica, embora nenhum tenha obtido desempenho satisfatório. Entre os pontos de preocupação, os pesquisadores citam a possibilidade de alguns LLMs vazarem documentos confidenciais e o fato de os robôs frequentemente caírem de escadas por falhas de percepção.

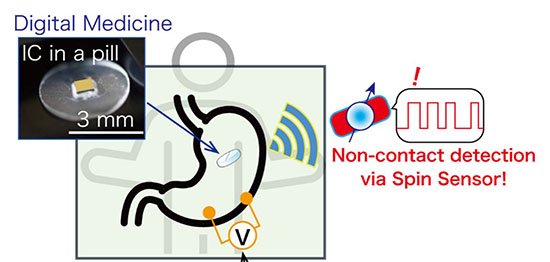

O estudo, publicado em versão pré-print, ressalta que LLMs vêm sendo usados para “orquestração” de decisões em projetos de robótica, enquanto algoritmos separados controlam motores e atuadores. Para a Andon Labs, entretanto, ainda há “muito trabalho” antes de esses sistemas assumirem tarefas físicas com segurança e precisão.

Com informações de TechCrunch