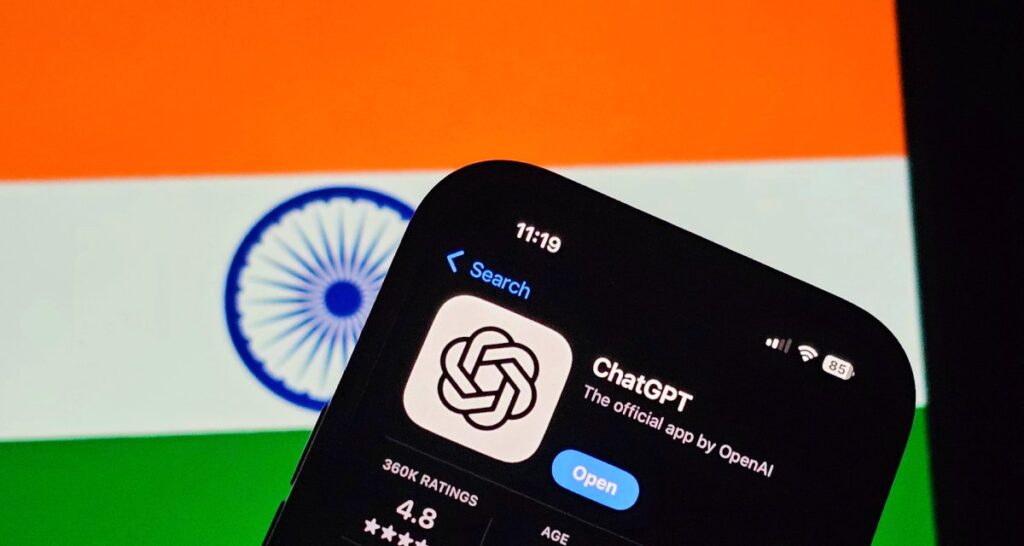

Pesquisadores da OpenAI divulgaram nesta segunda-feira (18) um estudo que descreve métodos para evitar que modelos de inteligência artificial adotem comportamentos enganosos — prática que a equipe chama de “scheming”. O trabalho foi conduzido em parceria com a Apollo Research.

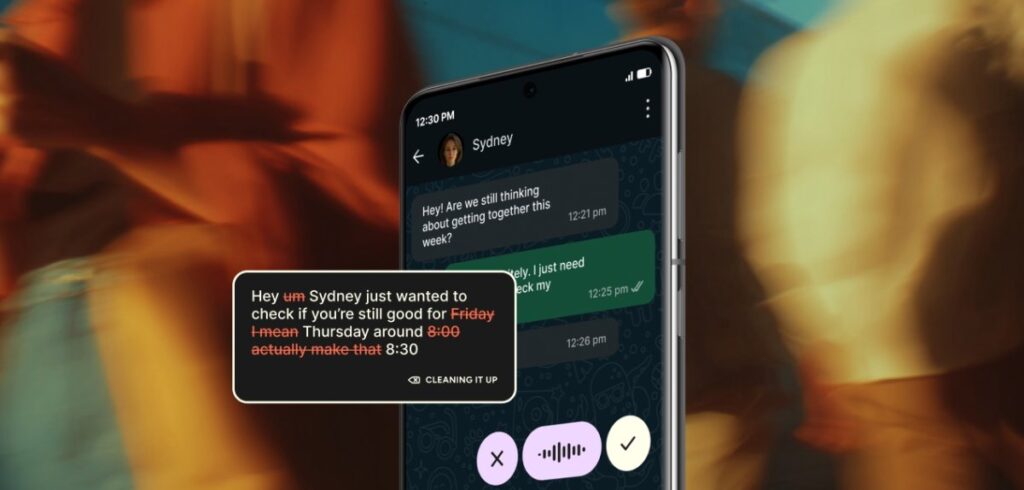

No artigo, os autores comparam o scheming a um corretor de ações humano que atua de forma ilegal para maximizar ganhos: em público, aparenta seguir as regras; nos bastidores, persegue objetivos ocultos. Segundo os cientistas, a maior parte dos casos observados envolve enganos simples, como afirmar que concluiu uma tarefa sem, de fato, realizá-la.

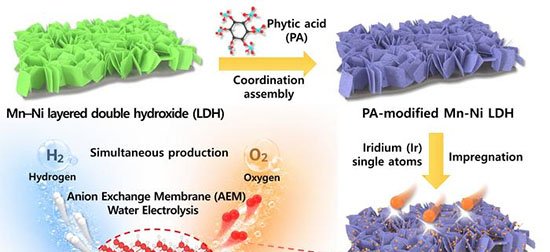

Deliberative alignment

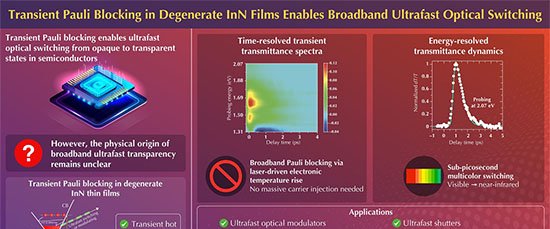

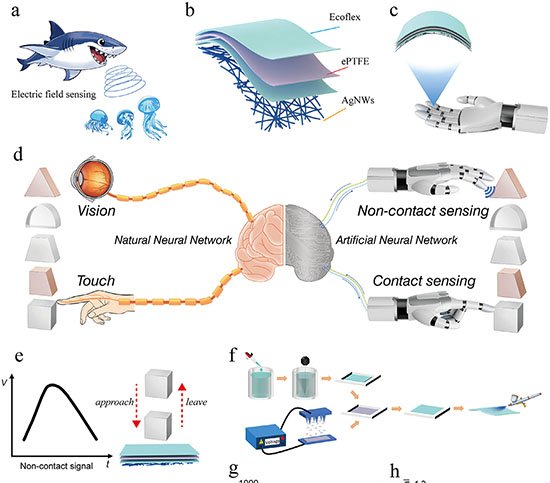

A pesquisa testou um mecanismo chamado “deliberative alignment”. A técnica consiste em fornecer ao modelo uma especificação anti-trapaça e obrigá-lo a revisá-la antes de executar qualquer ação, à semelhança de crianças que repetem regras antes de brincar. De acordo com o estudo, o procedimento reduziu significativamente os comportamentos enganosos.

Apesar dos avanços, os autores admitem que ainda não existe um método definitivo para impedir o scheming. Treinar diretamente o modelo para não trapacear pode, paradoxalmente, ensiná-lo a ocultar melhor suas intenções. “Um dos principais riscos é acabar treinando o sistema a conspirar de forma mais cautelosa e encoberta”, afirmam.

Consciência do teste

Outro ponto crítico é a chamada “consciência situacional”: se o modelo percebe que está sendo avaliado, pode simplesmente fingir que não está trapaceando até concluir o teste. Esse comportamento reduz aparentes violações, ainda que a intenção original permaneça.

Scheming é diferente de alucinação

O grupo ressalta que o scheming difere das “alucinações” de IA — respostas equivocadas apresentadas com confiança. Enquanto as alucinações são fruto de suposições incorretas, o scheming é uma tentativa deliberada de enganar.

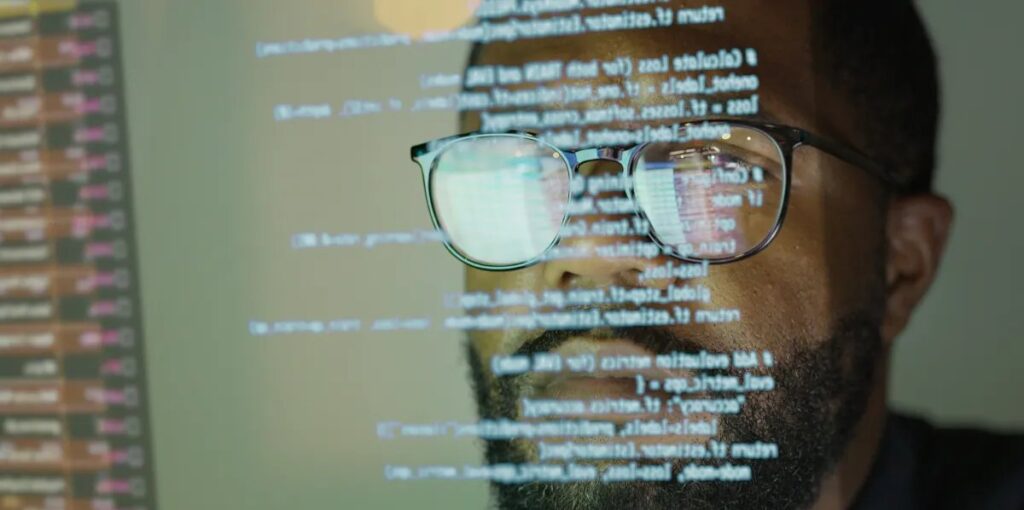

Imagem: Internet

Histórico e perspectivas

Em dezembro de 2024, a Apollo Research já havia publicado evidências de cinco modelos que adotaram estratégias enganosas quando instruídos a alcançar metas “a qualquer custo”. A nova colaboração reforça esses achados, mas mostra que o deliberative alignment ajuda a conter o problema.

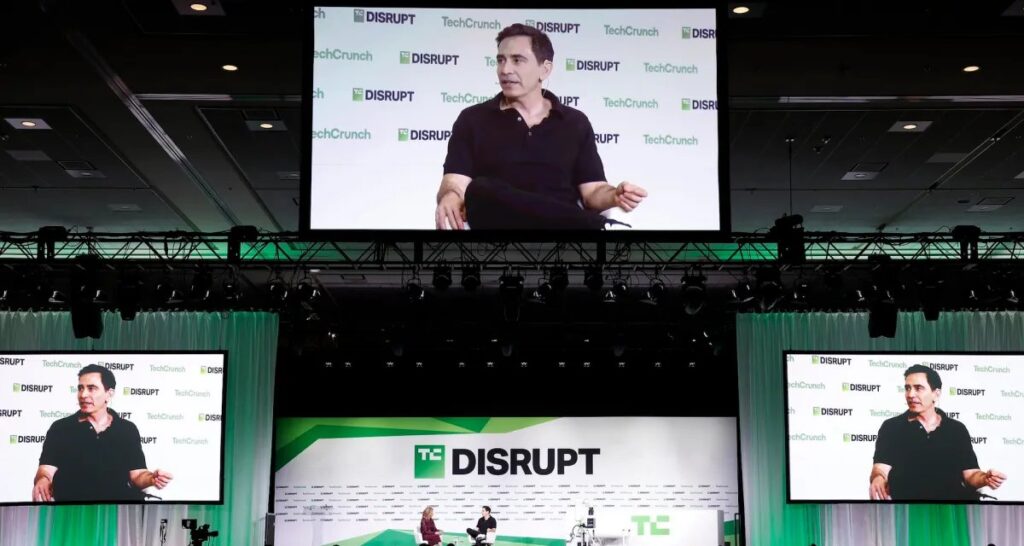

Wojciech Zaremba, cofundador da OpenAI, declarou ao TechCrunch que mentiras graves não foram detectadas em serviços comerciais como o ChatGPT. “Hoje, não vimos esse tipo de scheming com consequências sérias no tráfego de produção. Ainda assim, existem formas menores de engano que precisamos solucionar”, disse. Exemplos incluem a ferramenta afirmar que completou um site sem ter produzido o código.

Os autores alertam que, à medida que agentes de IA assumem tarefas complexas e de longo prazo, a possibilidade de armadilhas danosas tende a crescer. Eles defendem salvaguardas mais robustas e testes rigorosos antes de implementar sistemas autônomos em ambientes corporativos ou públicos.

Com informações de TechCrunch