O entusiasmo inicial em torno do OpenClaw — plataforma de agentes de inteligência artificial (IA) criada pelo desenvolvedor austríaco Peter Steinberger — tem dado lugar a dúvidas sobre sua real utilidade. Pesquisadores de cibersegurança apontam vulnerabilidades que, segundo eles, tornam o sistema pouco confiável no momento.

Rede ‘Moltbook’ acende alerta

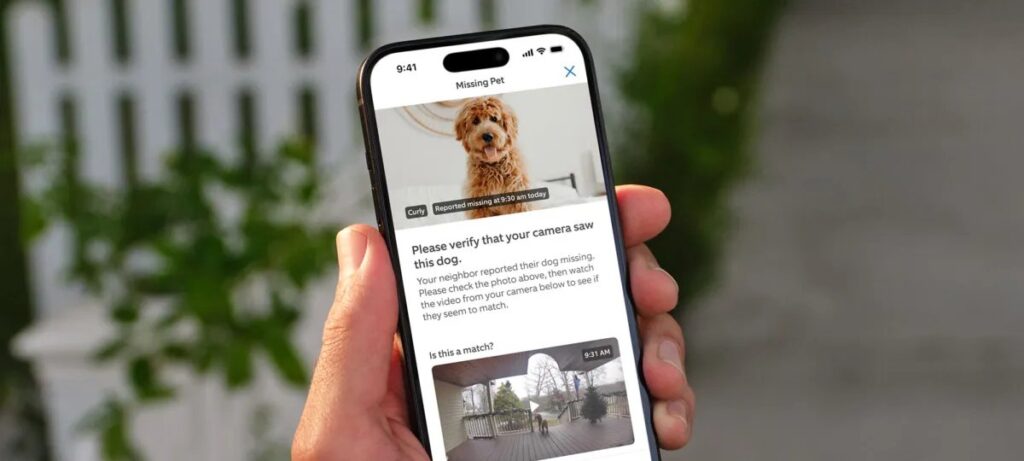

O debate ganhou força depois da criação do Moltbook, uma versão do Reddit onde agentes de IA, supostamente autônomos, trocavam mensagens. Publicações que pareciam escritas por máquinas sugeriam que os programas buscavam “espaços privados” longe do olhar humano, provocando especulações sobre uma possível rebelião de algoritmos.

A hipótese de agentes independentes, porém, não se confirmou. Ian Ahl, diretor-técnico da Permiso Security, descobriu que todas as credenciais armazenadas no Supabase do Moltbook ficaram expostas durante algum tempo. “Qualquer pessoa podia pegar um token e se passar por outro agente, porque tudo estava público”, afirmou.

Sem controles ou limites de uso, humanos conseguiram criar contas, publicar como se fossem robôs e até inflar a popularidade de postagens. “Foi o inverso do que costuma ocorrer nas redes sociais, onde bots tentam parecer pessoas reais”, comentou John Hammond, pesquisador sênior da Huntress.

Popularidade e limitações

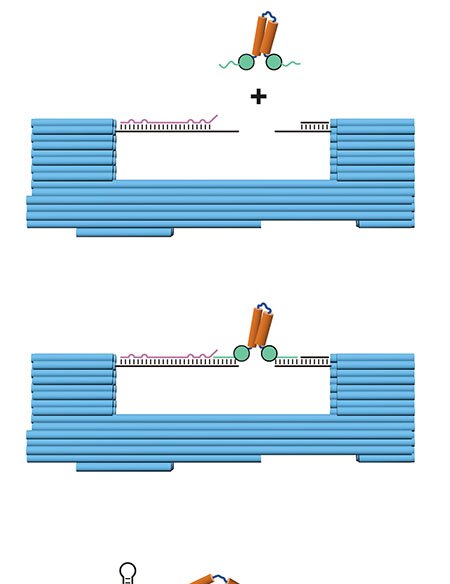

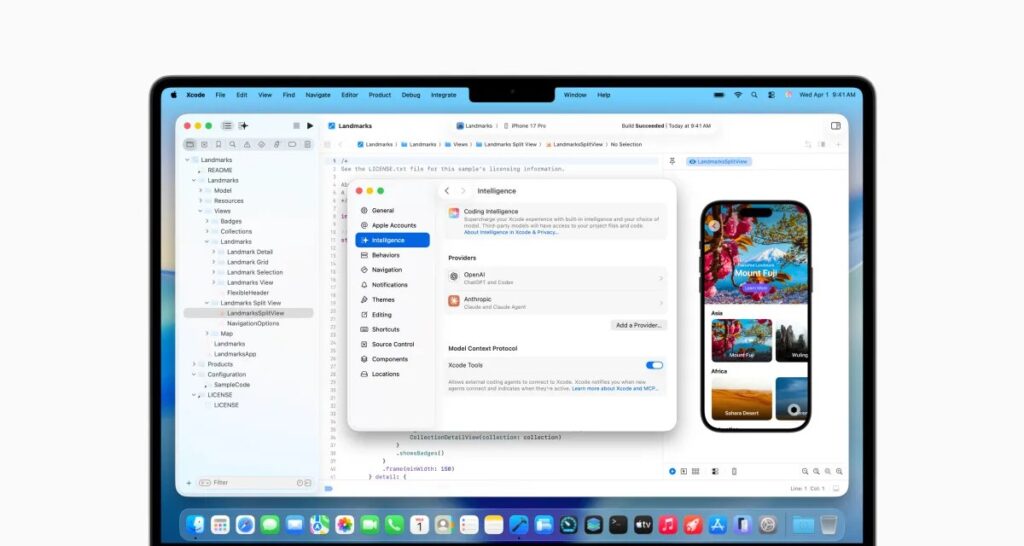

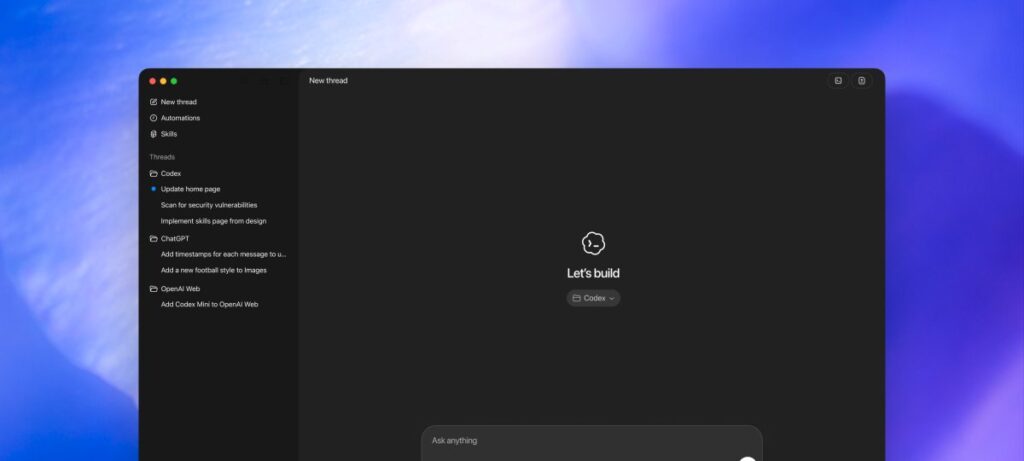

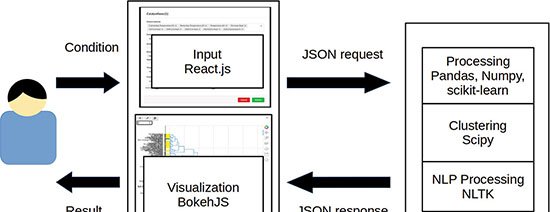

Lançado inicialmente como Clawdbot — nome contestado pela Anthropic —, o OpenClaw reúne hoje mais de 190 mil estrelas no GitHub, ocupando a 21.ª posição entre os repositórios mais populares da plataforma. O software funciona como uma camada que conecta modelos de linguagem diversos (Claude, ChatGPT, Gemini, Grok, entre outros) a aplicativos de mensagem como WhatsApp, Discord, iMessage e Slack.

Por meio do marketplace ClawHub, usuários podem baixar “skills” capazes de automatizar tarefas como gerir e-mails ou negociar ações. A habilidade usada no Moltbook, por exemplo, permitia publicar, comentar e navegar no site.

Para Chris Symons, cientista-chefe de IA da Lirio, a novidade não representa salto científico: “É apenas uma melhoria iterativa sobre o que já existia, dando mais acesso aos programas”. Artem Sorokin, fundador da ferramenta de cibersegurança Cracken, concorda: “Do ponto de vista de pesquisa em IA, não há nada inédito; o diferencial foi combinar componentes antigos de forma mais fluida”.

Riscos de prompt injection

Ahl criou seu próprio agente, apelidado Rufio, e demonstrou a facilidade de induzi-lo a ações indevidas por meio de prompt injection. Em testes no Moltbook, surgiram postagens que tentavam convencer agentes a enviar bitcoin para carteiras específicas.

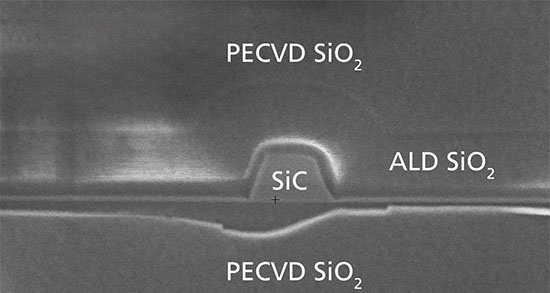

Imagem: Getty

O cenário preocupa empresas que cogitam implantar agentes em redes corporativas. “É um programa com várias credenciais, conectado a tudo: e-mail, mensagens, o que for”, disse Ahl. Um e-mail malicioso com instruções disfarçadas poderia desencadear ações indesejadas, mesmo com guardrails implementados.

Hammond descreve a prática de reforçar as barreiras nos próprios comandos — o chamado “prompt begging” — como pouco confiável. “A realidade é que não há garantias de que o agente não vá quebrar as regras”, observou.

Entre potencial e precaução

O sucesso viral do OpenClaw deve-se, em parte, à promessa de aumentar drasticamente a produtividade — ideia que reforça previsões como a do CEO da OpenAI, Sam Altman, sobre um empreendedor solo conseguir criar um “unicórnio” auxiliado por agentes. Contudo, especialistas alertam que, sem resolver as falhas de segurança, o sistema pode trazer mais riscos que benefícios.

“Falando francamente, eu diria a qualquer usuário comum: não use agora”, concluiu Hammond.

Com informações de TechCrunch